百度蜘蛛池租用揭秘:本文深入解析如何利用JavaScript构建高效蜘蛛池,探讨其工作原理和优化技巧,为用户提供构建和维护蜘蛛池的实用指导。

本文目录导读:

随着互联网的快速发展,信息获取的方式也日益多样化,在这个信息爆炸的时代,如何高效地获取和整理网络资源成为了一项重要的技能,JavaScript作为一种广泛使用的编程语言,在网页开发、服务器端编程等领域有着举足轻重的地位,本文将带您深入了解如何利用JavaScript构建蜘蛛池,以实现高效的网络资源采集。

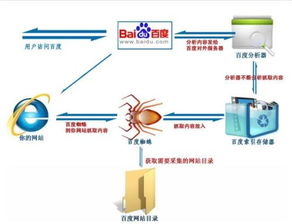

蜘蛛池,又称爬虫池,是指通过程序模拟搜索引擎蜘蛛,对网络上的网页进行抓取和索引的过程,蜘蛛池的作用在于提高信息采集的效率,减少重复抓取,从而降低服务器负载,构建蜘蛛池已经成为互联网行业的一项基本技能。

1、网页解析

JavaScript在蜘蛛池中的首要任务是对网页进行解析,通过使用DOM(Document Object Model)操作,我们可以提取网页中的文本、图片、链接等元素,常用的JavaScript库如jQuery、Puppeteer等,都为我们提供了丰富的API进行网页解析。

2、数据存储

蜘蛛池在抓取网页数据后,需要将数据进行存储,以便后续处理和分析,JavaScript中的数据库技术如MongoDB、Redis等,可以方便地实现数据的存储和检索。

3、网络请求

JavaScript中的XMLHttpRequest、fetch等API可以实现对HTTP请求的发送,在蜘蛛池中,我们可以通过这些API模拟搜索引擎蜘蛛的行为,对目标网页进行抓取。

4、防止反爬虫

为了提高蜘蛛池的稳定性,我们需要应对网站的反爬虫策略,JavaScript可以用来实现IP代理、请求头模拟、验证码识别等功能,从而降低被目标网站封禁的风险。

1、确定目标网站

我们需要明确蜘蛛池的目标网站,了解网站的结构和内容,以便制定合适的抓取策略。

2、选择合适的JavaScript库

根据需求,选择适合的JavaScript库进行网页解析、数据存储和网络请求,如Puppeteer、jQuery、axios等。

3、编写爬虫代码

编写爬虫代码,实现对目标网站的抓取,主要步骤包括:

(1)发送网络请求,获取网页内容;

(2)解析网页内容,提取所需数据;

(3)存储提取的数据,以便后续处理;

(4)实现递归抓取,遍历网站链接。

4、防止反爬虫策略

针对目标网站的反爬虫策略,编写相应的应对代码,如IP代理、请求头模拟、验证码识别等。

5、优化和测试

对蜘蛛池进行优化和测试,确保其稳定性和高效性,可以模拟不同场景下的抓取效果,调整爬虫参数,提高数据采集质量。

利用JavaScript构建蜘蛛池,可以帮助我们高效地采集网络资源,通过了解JavaScript在蜘蛛池中的应用,我们可以更好地应对网络资源采集的挑战,在实际应用中,我们需要不断优化和改进蜘蛛池,以提高其稳定性和效率,希望本文对您有所帮助。